El archivo robots.txt es un archivo fundamental en el mundo del SEO y la administración de sitios web. Es una herramienta simple pero poderosa que le indica a los motores de búsqueda (como Google, Bing, etc.) cómo deben interactuar con las páginas de un sitio web. Aunque su función puede parecer técnica, su uso adecuado puede mejorar la visibilidad y el rendimiento de un sitio en los motores de búsqueda.

¿Para qué sirve el archivo robots.txt?

El archivo robots.txt actúa como una guía para los motores de búsqueda. Este archivo le indica a los bots qué partes del sitio web pueden rastrear y cuáles deben evitar. De esta manera, puedes evitar que los motores de búsqueda indexen contenido que no quieres que aparezca en los resultados, como páginas duplicadas, archivos temporales o información privada.

Por ejemplo, si tienes una página de administración o una sección de tu sitio que no debe ser indexada, puedes indicarlo a través del archivo robots.txt.

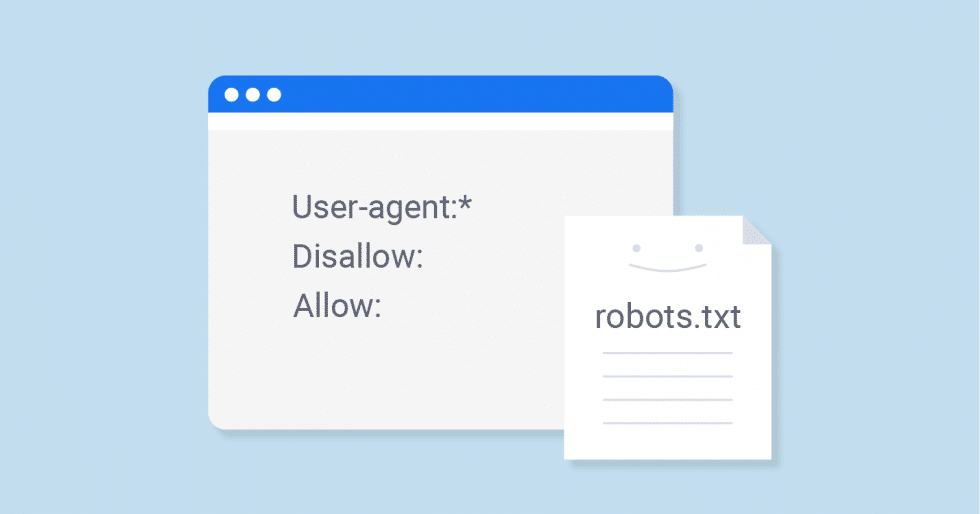

¿Cómo se estructura un archivo robots.txt?

El archivo robots.txt está compuesto por instrucciones o «reglas» que son entendidas por los bots de los motores de búsqueda. Estas instrucciones son muy simples y generalmente incluyen dos componentes principales:

- User-agent: Define a qué motor de búsqueda se aplica la regla.

- Disallow: Indica las rutas o páginas que no deben ser rastreadas.

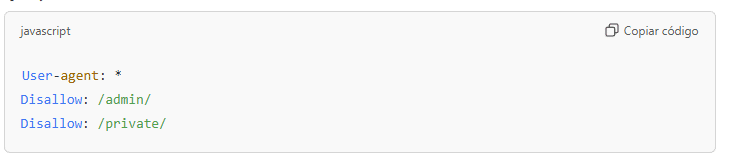

Ejemplo básico de robots.txt:

En este ejemplo, el archivo robots.txt le está diciendo a todos los motores de búsqueda que no rastreen las carpetas «admin» y «private» del sitio.

¿Puedo bloquear todo el sitio?

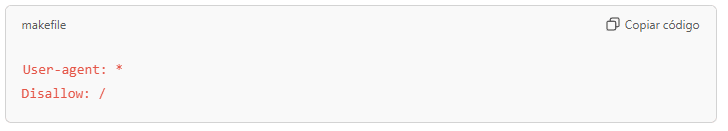

Sí, es posible bloquear completamente el rastreo de un sitio web utilizando el archivo robots.txt. Esto es útil, por ejemplo, si estás desarrollando un sitio y no deseas que los motores de búsqueda lo indexen aún. Aquí tienes un ejemplo:

Esta regla impide que cualquier motor de búsqueda rastree cualquier página del sitio.

Consideraciones importantes

Aunque el archivo robots.txt es útil, debe usarse con precaución. Un uso incorrecto podría hacer que se bloquee contenido importante o se reduzca la visibilidad del sitio web en los motores de búsqueda. Es importante revisar las reglas y asegurarse de que solo se bloquean las páginas que realmente deseas ocultar.

¿Por qué es importante tener un archivo robots.txt en tu sitio web?

El archivo robots.txt es esencial para la gestión adecuada del rastreo y la indexación de tu sitio. Un archivo bien configurado puede:

- Mejorar la indexación: Al permitir que los motores de búsqueda accedan solo a las páginas más relevantes.

- Evitar el contenido duplicado: Evitar que los motores indexen páginas que no aportan valor, como las de inicio de sesión o las páginas de administración.

- Optimizar el rendimiento: Reducir la carga en tu servidor al evitar que los bots rastreen áreas no deseadas.

¿Es obligatorio tener un archivo robots.txt?

No es obligatorio tener un archivo robots.txt en tu sitio web, pero es altamente recomendable si deseas un control más específico sobre cómo los motores de búsqueda rastrean tu contenido. Sin un archivo robots.txt, los motores de búsqueda rastrearán el sitio según su propio criterio, lo que podría no ser lo más eficiente.

¿Quieres saber más?

Si estás interesado en optimizar la visibilidad de tu sitio web y asegurarte de que esté correctamente configurado para los motores de búsqueda, ¡no dudes en contactarnos! Nuestro servicio de Posicionamiento SEO puede ayudarte a mejorar tu posicionamiento SEO y asegurarte de que tu archivo robots.txt y otras configuraciones estén correctamente implementadas.

¡Contáctanos hoy mismo y lleva tu sitio web al siguiente nivel!